苹果公司华人研究员抛弃注意力机制,史上最快的Transformer!新模型达成最低时间复杂度

2017年,一篇神奇的论文Attention is All You Need横空出世,目前已有两万多个引用,为后续的BERT,GPT类模型提供了基础的Transformer模型,在NLP,CV等多个机器学习领域大放异彩。

Transformer中一个重要的机制就是注意力(Attention),这也是论文标题中重点说明的,也是效果好的原因。

但谷歌的老对头苹果公司不这么想,近日,苹果公司在arxiv上上传了一篇论文,无需注意力机制的Transformer,即Attention Free Transformer (ATF)。

第一作者为华人Shuangfei Zhai,是毕业于宾汉姆顿大学的博士。

在attention效果好的时候,重新回顾不采用attention的研究方法就成了创新

论文的摘要中说明,AFT是Transformer的一个有效的变体,不再需要自注意力机制。

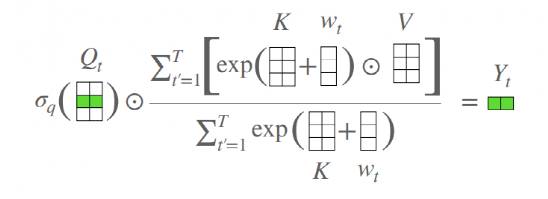

一个 AFT 层中,key和value首先与一组已学习的位置偏差组合在一起,其结果以元素级(element-wise)方式与query相乘。

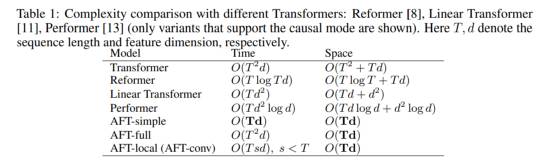

这种新的操作具有记忆线性复杂度(上下文大小和特征维度),使其既能兼容长输入文本,也能平衡模型大小。

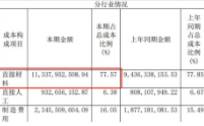

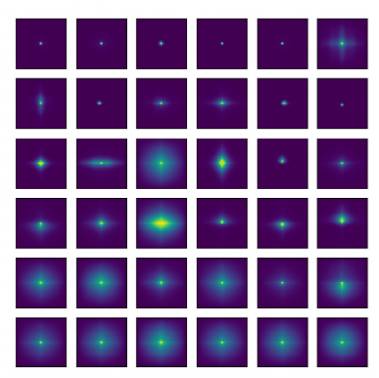

AFT这个基础模型在文中又称为AFT-full,可视化的结果如下所示。对于每个时间步t来说,AFT都是value的加权平均值,结果就是和query的element wise的乘法。

除此之外,文中还介绍了 AFT-local 和 AFT-conv 两种模型,它们利用了局部性和空间权重分配的思想,同时保持了全局连通性。

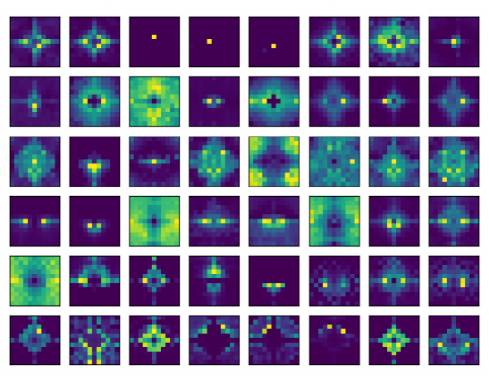

AFT-local主要借鉴了CNN的思想,把相邻二维attention矩阵给平均池化

AFT-simple是AFT-local的一个特殊情况,当s=0的时候,也就是没有位置偏差

AFT-conv学习到了相邻位置的偏差,也是从局部性的想法扩展而来,采用了空间查权重共享的想法,也就是卷积,这个模型对于视觉相关的任务来说特别好用。

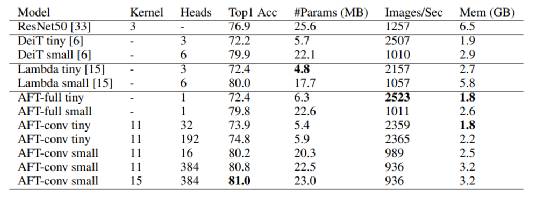

这个模型在两个自回归建模任务(CIFAR10和 Enwik8)和一个图像识别任务(ImageNet-1K 分类)上进行了广泛的实验,证明了 AFT 在所有的基准测试中都表现出了很好的竞争性能,同时也提供了很好的效率。

论文的结论就是AFT取代了原有attention机制中的点乘运算,并且在数据集上取得更好的结果,并且时间复杂度明显降低,这项工作将为Transformer类的模型提供参考。

论文在reddit社区上引发了激烈的讨论,有网友表示,你不需要卷积,你不需要注意力机制,你什么都不需要,能不能告诉我们到底需要什么?

有人回复道,我们需要价值数百万美元的硬件设备。

还有说全连接层is all you need

即将到来的下一篇文章:Nothing is all you need。

编辑按:本文转载至微信公众号 “新智元”, 贝壳投研经授发布

飞鲸投研从多维度分析,整理了一份《成长50》的名单,可以关注同名公众号:"飞鲸投研":feijingtouyan,进行领取(点击复制)

/阅读下一篇/